Olá pessoal de SEO! O Google publicou neste mês em seu Blog Oficial de Webmasters uma explicação detalhada sobre o rastreamento de páginas pelo Googlebot.

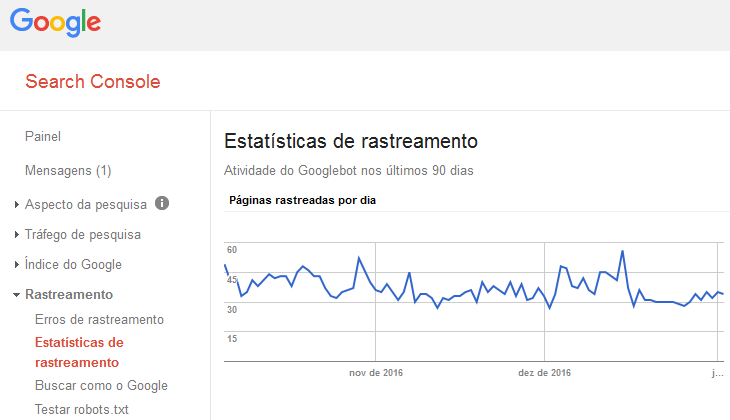

O título do artigo é “What Crawl Budget Means for Googlebot“, traduzindo seria “O que o orçamento de rastreamento significa para o Googlebot“, que nos ajuda a entender melhor como alguns detalhes de nosso site podem influenciar no rastreamento. Consta no próprio artigo do blog que não é algo que os webmaster devem se preocupar, mas é muito interessante saber com mais detalhes como funciona, até mesmo para entendermos melhor os gráficos exibidos no Google Search Console na tela de Estatísticas de Rastreamento (imagem em destaque).

Limite da Taxa de Rastreamento do Googlebot

Há um limite na taxa de rastreamento pelo Googlebot de forma que não sobrecarregue a largura de banda do servidor do site, e essa taxa pode variar de acordo com alguns fatores. Se um site responde rapidamente ao ser rastreado, aumentará essa taxa. Se o site é lento e possui erros de servidor (http status 500), diminuirá a taxa de rastreamento.

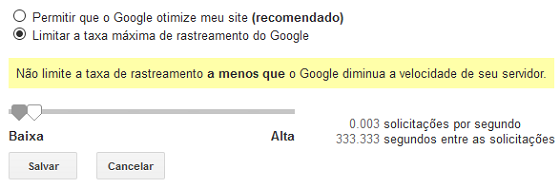

É possível alterar no Google Search Console a taxa de rastreamento máxima desejada, mas o Google informa que aumentar essa taxa não significa que o Googlebot irá atingi-la, e alerta também:

Recomendamos não limitar a taxa de rastreamento, a menos que você note problemas de carregamento do servidor que sejam realmente causados pelo Googlebot sobrecarregando o servidor.

Limitar a Taxa de Rastreamento no Google Search Console

Se mesmo assim você deseja colocar um novo limite máximo no rastreamento do Googlebot, a configuração será válida por 90 dias. Confira como alterar:

Dentro do Google Search Console, clique no ícone da engrenagem (canto superior direito) e em Configurações do site. Ao selecionar para limitar a taxa máxima de rastreamento, exibirá o gráfico abaixo – observe que há um alerta do Google para apenas fazer isso se o Googlebot estiver prejudicando o site.

O Google ainda diz:

Caso a página de configurações do site diga que sua taxa de rastreamento é “calculada como ideal”, só será possível reduzir essa taxa com o envio de uma solicitação especial. Não é possível aumentar a taxa de rastreamento.

Essa solicitação especial citada acima deve ser realizada através do link: https://www.google.com/webmasters/tools/googlebot-report

Demanda de Rastreamento

No artigo, o Google explica ainda a demanda de rastreamento: URLs mais populares são rastreadas com maior frequência para manter o índice do Google atualizado e livre de URLs obsoletas. É possível observar que páginas com bastante tráfego são atualizadas rapidamente no índice quando são alteradas (ex.: quando meta-tag title é atualizada).

Além disso, mudanças no site (ex.: redirecionamentos) podem aumentar a demanda de rastreamento para reindexar as novas URLs no índice.

Fatores Negativos para Rastreamento

Páginas com conteúdo de baixa relevância podem prejudicar o rastreamento e indexação do site, e o Google aponta em seu blog exemplos negativos em ordem de significância:

- URLs com conteúdo duplicado causado por parâmetros na URL – um exemplo são as páginas com filtragem, em que ao filtrar por preço, popularidade ou outros fatores, a página continua praticamente com o mesmo conteúdo apenas reorganizado de outra forma, porém com URL diferente em razão dos parâmetros inseridos.

- Páginas com Soft 404 – esse erro acontece quando o servidor responde com status http 200 para uma página que não existe ao invés de status 404 (não encontrado). É possível saber se há soft 404 em seu site através do Google Search Console em Rastreamento/Erros de Rastreamento.

- Páginas hackeadas

- “Espaço infinito”: o Google chama de “infinite space” páginas que possuem pouco conteúdo relevante ou excesso de URLs com conteúdo idêntico ou muito parecido. Quando esse tipo de problema é identificado, o webmaster é notificado através de mensagem no Google Search Console. A recomendação é tomar cuidado com parâmetros de URL, conforme 1º tópico, que podem gerar muitas combinações na URL para um mesmo conteúdo. No próprio Search Console, na tela Rastreamento/Parâmetros de URL, é possível informar quais parâmetros devem ser ignorados e evitar os problemas aqui descritos.

- Conteúdo de baixa qualidade e spam

O Google também diz que inserir no arquivo robots.txt a instrução crawl-delay não fará diferença, por não ser processada pelo Googlebot.